Trong bài trước đã hướng dẫn sử dụng Hive phân tích dữ liệu chứng khoán. Trong ví dụ đó, tôi sử dụng lệnh “load data local inpath” để đưa dữ liệu từ thư mục lưu trữ trên máy local vào tảng dữ liệu đã được tạo sẵn trong hive. Lệnh trên cũng đồng thời tạo thư mục NYSE trong workspace của Hive trên HDFS. Với lệnh trên, tôi phân vân rằng liệu với dữ liệu streaming (sử dụng Apache Flume liên tục đẩy dữ liệu vào HDFS) thì làm thế nào để Hive có thể đọc được (dữ liệu mới được tự động đẩy vào Hive table để phân tích). Rất may Hive đã làm cho tôi việc này. Để hiểu rõ hơn cơ chế đọc dữ liệu của Hive, tôi đã test một trường hợp sau:

Hiển thị các bài đăng có nhãn BigData. Hiển thị tất cả bài đăng

Hiển thị các bài đăng có nhãn BigData. Hiển thị tất cả bài đăng

Thứ Tư, 30 tháng 11, 2016

Thứ Ba, 29 tháng 11, 2016

Sử dụng Hive trong phân tích chiều hướng của cổ phiếu

Trong bài trước đã hướng dẫn cài đặt hive trong môi trường centos. Bài này sẽ hướng dẫn một case cụ thể, sử dụng Hive phân tích chiều hướng của hai loại cổ phiếu. Dữ liệu thử nghiệm được lấy từ ‘NYSE_daily_prices_Q.csv’ là dữ liệu của hai mã cổ phiếu QRR và QTM của sàn NewYork.

Hướng dẫn cài đặt Hive trong Centos

Trong bài trước đã giới thiệu tổng quan về một số công cụ phân tích dữ liệu trong hệ sinh thai hadoop. Bài này sẽ hướng dẫn cài dặt Apache Hive trong môi trường CentOS/RHEL.

Phân tích dữ liệu lớn với công nghệ Hadoop

Với sự phát triển của công nghệ và số lượng người dùng internet, một khối lượng khổng lồ đang được sinh ra hàng ngày gồm các loại dữ liệu đa cấu trúc như hình ảnh, video, weblog, dữ liệu thu nhận từ các cảm biến… Từ đó nảy sinh nhu cầu lớn về lưu trữ, xử lý, phân tích dữ liệu để từ đó khai phá các thông tin hữu ích

Thứ Ba, 22 tháng 11, 2016

Cài đăt JAVA 8 (JDK/JRE 8u111) trên CentOS/RHEL và Fedora

Hadoop được xây dựng trên ngôn ngữ Java, vì vậy, để cài đặt được Hadoop, trước tiên phải cài đặt môi trường Java cho tất cả các máy trong cụm máy chủ. Tài liệu dưới đây hướng dẫn cài đặt Java 8 trên môi trường CentOS/RHEL và Fedora. JDK 8 được xuất bản vào tháng 3, 2014 . Có thể tham khảo thêm về phiên bản trên tại đây.

Thứ Hai, 21 tháng 11, 2016

Keedio FTP Flume Source

Keedio-flume-ftp was created to meet the

need of processing information stored on a FTP server. Information is

processed by Apache Flume, whose base data information unit is an

“event”.

Usually, in an FTP server, data is

loaded in bulk, which is a completely different usage paradigm than the

event-based paradigm on which Flume relies.

Nhãn:

ApacheFlume

,

BigData

,

DataIngestion

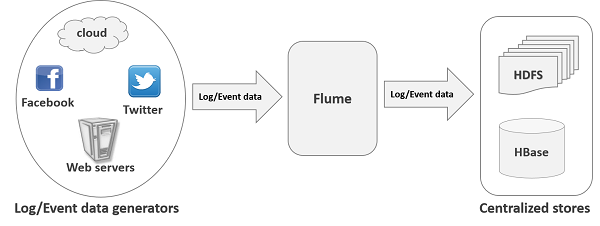

Apache Flume - Giới thiệu

What is Flume?

Apache Flume is a tool/service/data ingestion mechanism for collecting aggregating and transporting large amounts of streaming data such as log files, events (etc...) from various sources to a centralized data store.Flume is a highly reliable, distributed, and configurable tool. It is principally designed to copy streaming data (log data) from various web servers to HDFS.

Nhãn:

ApacheFlume

,

BigData

,

DataIngestion

Đăng ký:

Nhận xét

(

Atom

)